思科認證350-801考試詳情指南

一、認證背景

350-801考試是思科認證中的一項重要考試,專注於統一通信和協作技術領域。它是思科認證路徑中的CCNP Collaboration認證和CCIE Collaboration認證的基礎考試。此認證考試的目的是確認考生對實施和操作核心協作技術的知識。在當今世界,協作技術在各種行業和領域中發揮著重要作用,包括教育、醫療、商業和政府部門等。具有此類技能的專業人員可以幫助企業和組織改善其溝通效率,從而提高生產力和服務質量。

二、考試內容

350-801考試的內容主要包括以下幾個部分:

協作基礎:這部分考試內容包括瞭解和配置思科的協作基礎知識和技能,包括協作架構、協作部署模型、協作的組件和功能等。

音頻網絡:這部分考試內容涵蓋了對思科的音頻網絡設備和技術的瞭解和配置,包括思科的音頻網絡設備、音頻網絡的協議和標準、以及設計和實施音頻網絡的最佳實踐等。

協作應用:這部分考試內容包括對思科協作應用的瞭解和配置,包括思科的協作應用如Cisco Unified Communications Manager、Cisco Unified Communications Manager Express、Cisco Unity Connection等。

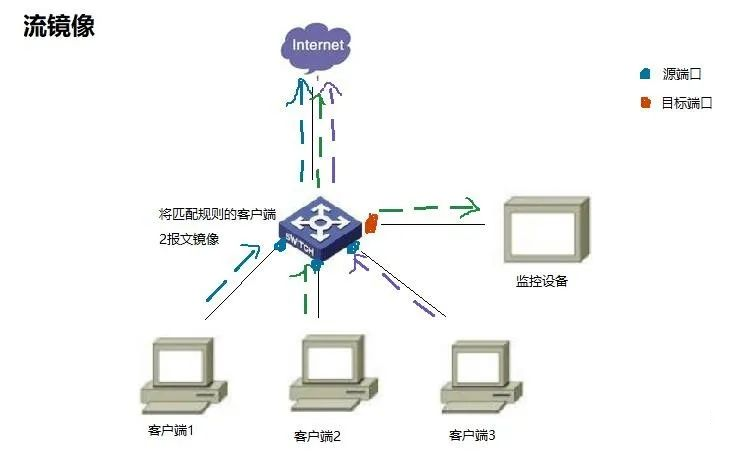

質量服務(QoS)和安全:這部分考試內容包括對思科協作網絡中的QoS和安全的理解和運用,包括QoS的原理和實施、思科協作網絡的安全策略和解決方案等。

統一通信和協作解決方案的設計:這部分考試內容包括設計和實施思科的統一通信和協作解決方案,包括對解決方案的需求分析、解決方案的設計和實施、以及解決方案的優化和故障排除等。

三、所適用人群

此考試主要適用於以下專業人士:

網絡工程師:這些專業人員需要了解和配置網絡設備,包括路由器、交換機和防火牆等。他們需要了解網絡的運作原理,並能夠解決網絡問題。

系統工程師:這些專業人員需要了解和配置企業的IT系統,包括服務器、存儲設備和應用程序等。他們需要了解IT系統的運作原理,並能夠解決系統問題。

支持工程師:這些專業人員需要提供技術支持,解決客戶的技術問題。他們需要了解各種技術產品和解決方案,並能夠有效地解決問題。

協作工程師:這些專業人員需要了解和配置協作技術和解決方案,包括音頻和視頻會議系統、即時通訊工具和協作平台等。他們需要了解協作技術的運作原理,並能夠提供協作解決方案。

四、學習方法及學習重點

為了通過350-801考試,考生需要專注於以下重點:

理解和應用協作基礎:考生需要對思科的協作基礎知識和技能有深入的理解,並能在實際環境中應用這些技術。這需要學習和了解協作的基本概念,包括協作的架構、協作的部署模型、協作的組件和功能等。

了解並配置音頻網絡:考生需要瞭解並熟悉思科的音頻網絡設備和技術。這需要學習和了解音頻網絡的基本概念,包括音頻網絡的設備、音頻網絡的協議和標準、以及設計和實施音頻網絡的最佳實踐等。

理解並配置協作應用:考生需要對思科的協作應用有深入的理解,並能配置這些應用。這需要學習和了解協作應用的基本概念,包括思科的協作應用如Cisco Unified Communications Manager、Cisco Unified Communications Manager Express、Cisco Unity Connection等。

掌握QoS和安全:考生需要對思科協作網絡中的QoS和安全有深入的理解。這需要學習和了解QoS和安全的基本概念,包括QoS的原理和實施、思科協作網絡的安全策略和解決方案等。

設計和實施統一通信和協作解決方案:考生需要能夠設計和實施思科的統一通信和協作解決方案。這需要學習和了解解決方案的基本概念,包括對解決方案的需求分析、解決方案的設計和實施、以及解決方案的優化和故障排除等。

五、官方考試費

考試的費用因地區和考試類型而異,具體的費用應在思科的官方網站上查詢。一般來說,思科的考試費用包括考試本身的費用和可能的註冊費。此外,考生還需要考慮到準備考試的其他成本,如購買參考書籍,參加培訓課程等。

六、授權考試中心

考試通常在思科認證的考試中心進行,考生可以在思科的官方網站上查找最近的考試中心。這些考試中心提供了一個專業的環境,讓考生可以專心參加考試。考試中心通常提供的設施包括安靜的考試環境、現代化的設備和友好的工作人員等。

七、預約考試流程

要預約考試,考生需要先在思科的官方網站上註冊一個帳號,然後選擇考試,選擇考試中心,並支付考試費用。在考試當天,考生需要帶上有效的身份證件,按時到達考試中心。

八、認證有效期

思科的CCNP Collaboration認證和CCIE Collaboration認證的有效期通常為三年。在此期間,考生需要通過再認證考試或完成其他再認證要求以保持認證的有效性。如果考生在認證有效期內未能完成再認證要求,則認證將過期,考生需要重新參加考試以獲得認證。

九、重認證政策

思科有明確的重認證政策,考生可以通過參加和通過相關的再認證考試或完成思科認可的持續教育活動來完成重認證。持續教育活動可以包括參加思科的培訓課程、參加思科的網絡學院課程、參加思科的研討會或活動等。

十、有樣本預覽

為了幫助考生更好地準備考試,思科在其官方網站上提供了一些考試樣題。這些樣題可以幫助考生了解考試的格式和題型,並可以用來測試和提高自己的知識和技能。考生可以利用這些樣題來評估自己的學習進度,並確定是否需要進一步的學習或實踐。

以上就是思科認證350-801考試的詳細資訊,希望這些資訊能夠幫助您更好的準備考試。無論您是剛剛開始您的IT職業生涯,還是已經在此領域工作多年,這個考試都是驗證您技術能力和知識的絕佳方式。另外,獲得這個認證將是您職業生涯的一個重要里程碑,它將證明您的專業技能,並可能為您帶來更多的職業發展機會。