【摘要】博通收購VMware引發企業擔憂和重新評估,許多企業開始考慮替換VMware,twt社區高端製造企業用戶會員也圍繞VMware的替換路線進行了一系列交流探討。本文基於此,對社群使用者探討較多的其中兩條技術路線-虛擬化軟體平替與超融合架構兩種路線的差異進行了比較全面的比較。

【主筆專家】楊承龍,某機械製造企業雲端平台架構師,負責IT基礎設施規劃與建設,專注於雲端平台、資料中心、容災備份等領域,具備豐富的專案經驗,曾主導集團級私有雲平台專案規劃與落地,專案上線後,實現資源集約化管理,統一技術架構,受到分子公司廣泛好評,協助集團業務雲上融合創新。

相關推薦:製造企業採用IaaS雲端平台取代VMware:優劣勢分析、遷移困難及解決方案

一、 高階裝備製造業VMware虛擬化替換背景

面對 VMware 的收購風波和一系列訂閱模式、產品組合、授權模式調整,不少用戶會猶豫,是繼續使用原有 VMware 產品,還是採用新的產品組合,或是轉向其他替代方案?現階段真的有必要替換 VMware 產品嗎?

首先要先明確的一點是,並非所有使用者都必須立刻決定是否要將原有 VMware 產品進行替代或更換為新的產品組合。使用者的「決策緩衝時間」取決於以下兩個因素:

1. 原來訂購的產品服務是否即將到期?

如果用戶使用的產品服務即將到期,由於無法以原價格續保,可能必須選擇使用新的訂閱許可,或停止原產品的使用。如果不進行續保,缺乏原廠技術支援終究是一個潛在的風險點。

2. 仍在使用中的 VMware 產品是否需要進行版本升級或擴充?

版本升級一方面可以增加功能、提升效能、修補 bug 和安全漏洞;另一方面,正在使用的系統可能需要隨業務規模成長而擴充。若未採用 Broadcom 的新訂閱模式,將無法升級原先使用的 VMware 產品。在沒有版本升級或擴容需求的期間內,不必急著做出更換產品的決定。

基於以上因素,不少製造業用戶將VMware 替代提上日程,為了幫助用戶順利完成從VMware 替代方案評估到產品落地的一系列環節,我們透過這篇文章,對VMware 替代場景下用戶經常遇到的問題進行了梳理,集中分析虛擬化軟體平替和轉換超融合架構兩種路線的主要特點、成本和需求場景,供使用者參考。

二、VMware虛擬化替換路線分析

(1)圍繞著目前實現VMware替換的多種技術路線,twt社群高端裝備製造用戶會員進行了路線傾向性調查的投票,數據如下:

根據投票數據可以看出,大部分用戶會選擇虛擬化平替、遷移至IAAS雲端平台兩種路線,筆者認為,在做技術路線選型的時候,需要綜合考慮公司業務發展需求、新平台的穩定性、替換成本等多面向因素,對於中大型製造業,業務系統規模較大,有雲原生改造需求,適合選擇雲端平台。對於小型製造業,業務系統相對簡單、數量不多,基礎虛擬化平台可滿足業務發展,選擇超融合平台作為基礎架構,可以在不犧牲性能和擴展性的前提下,更好地控制總體擁有成本。

(2)虛擬化平替與轉換超融合架構兩種技術路線的主要特點

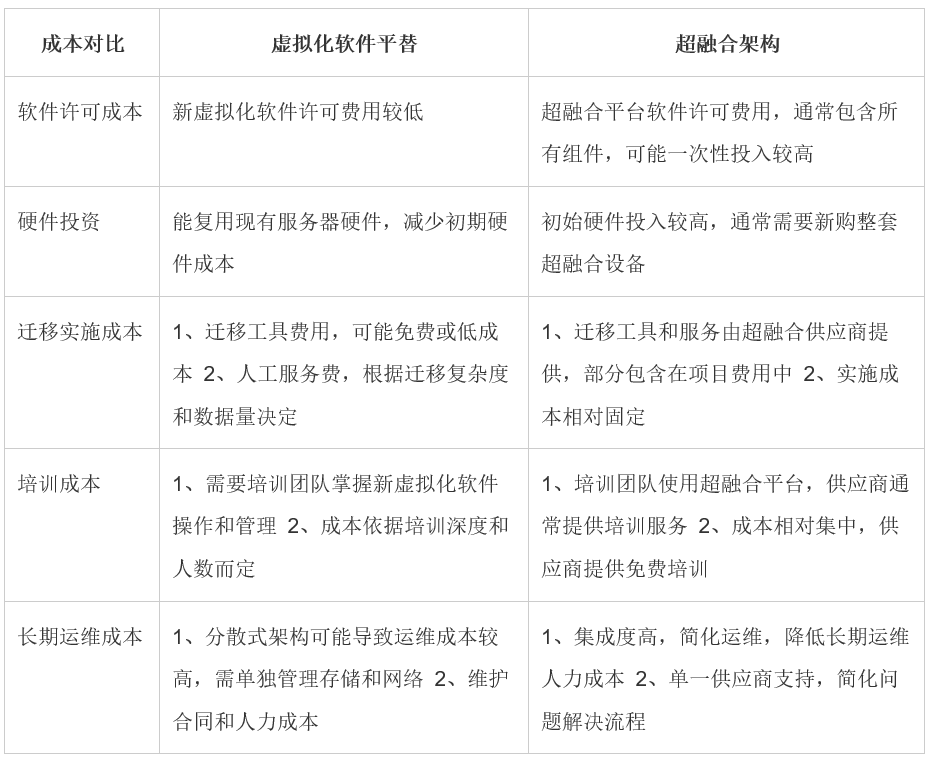

(3)虛擬化平替與轉換超融合架構兩種技術路線的成本對比

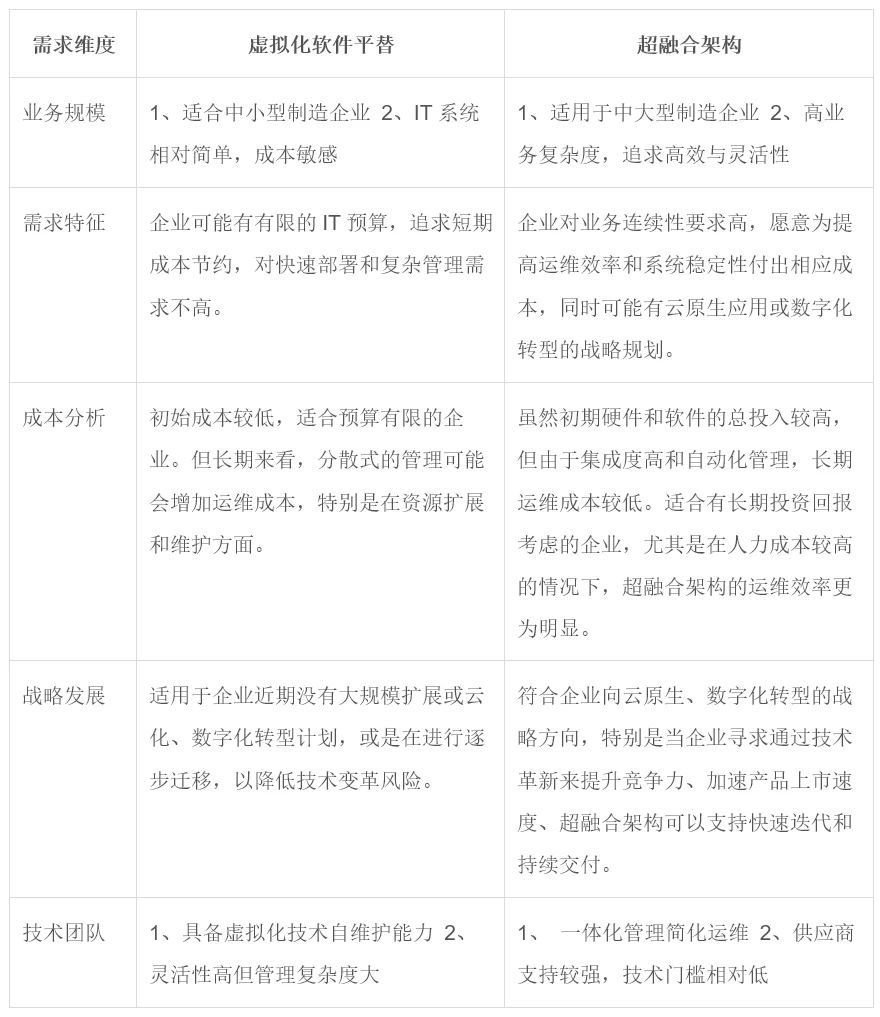

(4)虛擬化平替與轉換超融合架構兩條技術路線的需求場景

高階製造對產線業務持續穩定可靠的要求十分嚴格,更推薦架構不變或微調平替VMware,即使存在遷移,也是無感或微影響,業務層面不會進行大範圍的改造。

選擇虛擬化軟體平替或轉換超融合架構,應基於企業的實際業務需求、財務狀況、技術團隊能力以及長遠發展策略。中小型企業可能更注重成本控制和短期效益,傾向平替方案;而中大型企業或有明確數位轉型策略的企業,可能更偏好超融合架構帶來的長期維運效率和業務彈性。每種路徑的選擇都需經過全面的評估和規劃,確保技術方案與業務目標相符。

三、採用虛擬化軟體平替和轉換成超融合架構路線的困難點

製造業的IT系統複雜度高,特別是中大型企業,對穩定性和安全性有嚴格要求,因此在進行VMware替換時,無論是選擇虛擬化軟體平替或轉換超融合架構,都會面臨一系列的難點與挑戰。

1.虛擬化軟體平替的難點

1) 相容性問題:新虛擬化軟體與現有應用程式、作業系統、硬體的相容性驗證工作量大,可能導致遷移後出現未知錯誤。

2) 效能差異:新舊平台間可能存在效能差異,需進行充分測試確保不影響生產環境運作效率。

3) 遷移風險:資料遷移過程中可能遇到資料遺失或損壞的風險,需要周密的遷移計畫和回溯策略。

4) 管理工具整合:原有的VMware管理工具和流程可能無法直接沿用,需要重新整合或尋找替代方案。

2.轉換超融合架構的難度

1) 成本投入:超融合架構初期投資較高,包括軟硬體購置、部署與培訓,對預算有限的企業構成壓力。

2) 技術堆疊變更:從傳統架構轉向超融合架構涉及整個IT基礎架構的變革,技術堆疊的轉變對組織能力要求高。

3) 業務連續性保障:超融合架構的部署和遷移過程中需確保生產系統的連續運行,任何中斷都可能造成重大損失。

4) 供應商依賴:採用超融合架構可能帶來供應商鎖定,限制未來的技術選項和議價能力。

3.共同面臨的挑戰

1) 業務遷移風險評估:全面評估替換對業務流程、上下游合作夥伴及客戶體驗的潛在影響,充分評估遷移風險,並制定最小化干擾的遷移計畫。

2) 長期策略匹配:所選的技術路線需與企業長期的數位轉型、智慧製造策略相契合,避免短期內再次面臨技術升級的挑戰。

綜上所述,製造企業在進行VMware替換時,無論採取哪種技術路線,都需要綜合考慮技術、成本、業務連續性、策略性匹配等多方面因素,系統化地規劃VMware替換方案,制定詳盡的遷移計畫和風險因應策略,有效控制整體成本,同時確保業務平穩過渡和長期的經濟效益。