思科联天下

● 思科為人工智慧規模的資料中心和雲端提供動力和保護。 無論應用和裝置如何分佈或聯接,思科均能確保其安全。

● 當今高度離散的網路世界,漏洞從出現到被利用的時間正在縮短,而防禦資料中心日益複雜的威脅環境已經超出了人力所能處理的範圍。

● Cisco Hypershield 能夠在客戶需要的任何地方提供安全保護,無論是雲端、資料中心、工廠車間或醫院影像室,都能夠隨時隨地保障其安全。

● 透過AI原生安全功能,客戶可以自主分段其網絡,無需補丁即可享受分散式和近乎即時的漏洞保護,同時享受零停機時間的自動軟體升級服務。

2024年4月24日,北京—全球科技領導廠商思科日前正式推出資料中心與雲端安全的全新技術,以因應AI變革對IT基礎設施日益增長的需求。

思科推出業界首創的Cisco Hypershield,重新建構企業運用並保護人工智慧和其他現代工作負載的方式。 這項前所未有的創新,加上思科近期宣布的利用乙太網路交換、晶片和算力產品組合加速人工智慧基礎設施建設,以及與NVIDIA公司的合作,思科進一步拓展了能為防守方所提供的安全支持 。

Hypershield能夠在客戶需要的任何地點提供保護,包括公有和私有資料中心、雲端平台和實體位置中的應用程式、裝置和資料。 Hypershield將人工智慧需求考慮在內,進行設計和構建,旨在幫助企業實現超越人力所能及的安全成果。

Cisco Hypershield是思科有史以來最重大的安全創新之一。 思科在資料、安全、基礎架構和視覺化平台的實力,都令我們在協助客戶充分發揮人工智慧潛能方面具有得天獨厚的優勢。

——羅卓克

思科董事長

兼首席執行官

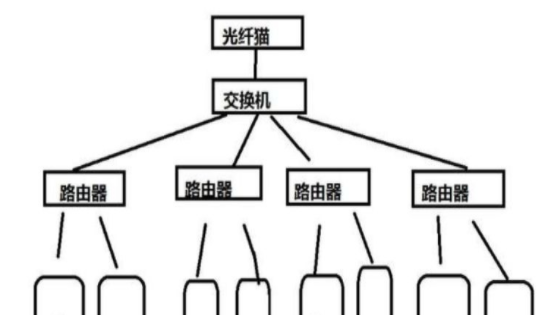

Hypershield是一種革命性的全新安全架構。 它採用的技術最初僅針對超大規模公有雲;現在,則拓展為可供各種規模的企業IT團隊使用。

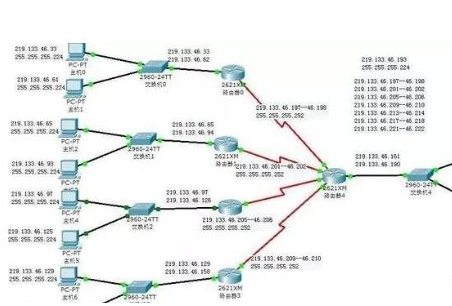

Hypershield更像是一種安全網絡,而不僅僅是安全屏障,它使安全策略得以部署到任何需要它的地方。 無論是資料中心內的每個應用服務、公有雲中的每個Kubernetes集群,或是每個容器和虛擬機器(VM),Hypershield都能為其提供保護。

Hypershield甚至將每個網路連接埠轉變為高效能的安全執行點,為雲端、資料中心、工廠車間或醫院影像室帶來全新的安全保障。 這項新技術能夠在幾分鐘內阻斷應用漏洞,並迅速阻止其橫向移動。

AI有潛力使全球80億人擁有與800億人相同的影響力。 在這個充滿無限可能的時代,我們必須重新構想資料中心的角色,也就是資料中心的連結方式、安全保障、營運模式和擴展能力。 Cisco Hypershield的強大之處在於,它可以在任何需要的地方提供安全性,無論是軟體、伺服器,還是未來的網路交換器。 當您擁有一個包含數十萬個安全執行點的分散式系統時,簡化管理至關重要。 我們需要以更低成本實現更高等級的自動化。

——Jeetu Patel

思科全球執行副總裁

安全與協作事業部總經理

Hypershield的安全執行分為三個不同的層次:軟體、虛擬機器以及網路和算力伺服器與設備,並利用了在高效能運算和超大規模公有雲中廣泛使用的強大硬體加速器。

Hypershield基於三大支柱構建:

三大支柱

●人工智慧原生:Hypershield以自動化和可預測為核心進行設計,一旦建立信任,Hypershield就可以實現自我管理,實現規模化的高度離散佈局。

● 雲端原生:Hypershield基於開源eBPF(Extended Berkeley Packet Filter)構建,是聯接和保護超大規模雲端雲端原生工作負載的預設機制。 思科預計將在本月完成為企業提供eBPF的領先供應商Isovalent的收購。

● 超分散式:思科正在徹底改變傳統網路安全性的工作方式,將高階安全控制嵌入伺服器和網路架構中。 Hypershield涵蓋所有的雲端平台,並利用資料處理單(DPU)等硬體加速功能來分析和回應應用程式和網路行為中的異常,為更需要保護的工作負載提供更強安全保護。

憑藉在網路、安全以及廣泛的合作夥伴生態系統方面的業界領先專業知識,思科致力於與NVIDIA共同建構和優化人工智慧本地安全解決方案,以保護和擴展未來的資料中心。

這項合作包括利用NVIDIA Morpheus人工智慧網路異常檢測框架,加速網路異常檢測,以及利用NVIDIA NIM微服務,為企業提供客製化的安全人工智慧助理。

NVIDIA的整合式加速器系列產品結合了GPU和DPU運算的力量,保障了Cisco Hypershield從雲端到邊緣的強大安全性。

各行各業的企業都在尋求能夠保護他們免受不斷擴大的網路威脅的安全解決方案,思科與NVIDIA共同利用人工智慧的力量,提供強大而極其安全的資料中心基礎設施,將幫助企業轉型並造福 全球客戶。

——Kevin Deierling

NVIDIA網絡

資深副總裁

作為一項革命性的全新安全架構,Hypershield正在解決當今複雜威脅環境下客戶面臨的三大關鍵挑戰:

三大關鍵挑戰

●分散式漏洞防禦:攻擊者擅長利用新發布的漏洞進行攻擊,其速度往往快於防守方進行修補程式更新的速度。 根據思科Talos威脅情報的數據,防守方每天幾乎要面對100個新的漏洞,可能導致災難性的後果。 Hypershield透過自動測試和部署補償控制措施到分散式執行點結構中,在幾分鐘內提供保護。

● 自主分段:一旦攻擊者進入網絡,分段就是阻止其橫向移動的關鍵。 Hypershield持續觀察、自動推理和重新評估現有策略,以自主地對網路進行分段,從而在大規模複雜環境阻隔攻擊。

● 自動驗證升級:Hypershield利用雙層資料平面,自動化了測試和部署升級的極為繁瑣和耗時的流程。 這種全新的軟體架構允許將軟體升級和策略變更放置在數位孿生中,並利用客戶獨特的流量、策略和功能組合進行測試,繼而在零停機情況下進行更新。

Cisco Hypershield是思科人工智慧驅動的統一跨網域安全平台安全雲端(Security Cloud)的一部分,預計2024年7月全面上市。

隨著思科完成對網路安全軟體公司Splunk的收購,客戶能夠在完整數位化足跡中獲得卓越的可見度和洞察力,從而獲得前所未有的安全保護體驗。

AI不僅是向善的力量,也被用於不法目的,讓駭客能夠逆向工程補丁並在極短時間內創建漏洞利用。 思科希望透過AI解決方案來解決AI帶來的問題,因為Cisco Hypershield旨在透過幾分鐘內保護新漏洞不被利用,從而讓防守方重新獲得優勢,而不是等待補丁實際部署所需的數天、 數週甚至數月。 隨著漏洞數量的不斷增加,攻擊者大規模利用這些漏洞的時間也不斷縮短,顯然僅靠修補程式已無法跟上這一趨勢。 像Hypershield這樣的工具對於應對日益狡猾的惡意網路攻擊來說至關重要。

——Frank Dickson

IDC安全與信任部門

集團副總裁

Cisco Hypershield旨在解決現代、AI規模資料中心所面臨的複雜安全挑戰。 思科對於能夠無縫整合從網路到終端的自我管理網路架構的願景,將有助於重新定義大規模安全的可能性,例如,在超分散式環境中實現這種層級的可見性和控制,能夠 防止攻擊者的橫向移動,這得益於一種自主且高度有效的獨特分段方法。 儘管這聽起來可能有些不可思議,但鑑於近期AI的進步以及eBPF等雲端原生技術的成熟,此刻正當時。

——Zeus Kerravala

ZK研究創辦人

兼首席分析師

在AHEAD,我們堅信網路安全應該融入我們所做的一切。 附加的安全措施成本更高,效果更差,Cisco Hypershield確保網路安全防護融入企業架構之中。 分散式漏洞保護將為網路安全中的防守方帶來巨大勝利——傳統的合成修補程式主要局限於邊緣設備,一旦攻擊者突破邊界,就允許其進行橫向移動。 這對網路防守方來說,真是個好消息!

——Steven Aiello

AHEAD

首席資訊安全官

思科(NASDAQ:CSCO)是全球科技領導廠商,致力於安全地連接一切,使一切成為可能。 我們的目標是透過重新定義應用、賦能混合辦公、保護企業安全、基礎架構轉型,幫助客戶實現永續發展目標,為所有人打造一個包容性的未來。 您可以在cisco.com.cn上獲取更多信息,並關注我們的微信公眾號“思科聯天下”。

思科和思科標誌是思科或其附屬機構在美國和其他國家地區的商標或註冊商標。 您可以查看Cisco商標清單www.cisco.com/go/trademarks,其中提及的第三方商標是其各自所有者的財產。 使用「夥伴」一詞並不能直接表示思科與任何其他公司之間有合作關係。